IA generativa desafía a la seguridad bancaria: Estafadores crean contenido casi perfecto con textos y voces falsas.

La inteligencia artificial generativa está dotando a los estafadores de nuevas y poderosas armas, desde textos de estafa redactados con fluidez hasta actores malintencionados que clonan voces y superponen rostros en los vídeos.

“Quería informarle de que Chase le debe un reembolso de US$2.000. Para agilizar el proceso y garantizar que reciba el reembolso lo antes posible, siga las instrucciones que se indican a continuación: 1. Llame al servicio de atención al cliente de Chase al 1-800-953-XXXX para preguntar por el estado de su reembolso. Asegúrate de tener a mano los datos de tu cuenta y cualquier información relevante… “

Si ha realizado operaciones bancarias con Chase y ha recibido esta nota en un correo electrónico o un mensaje de texto, podría pensar que es legítima. Suena profesional, sin frases peculiares, errores gramaticales o saludos extraños característicos de los intentos de phishing que nos bombardean a todos estos días. No es de extrañar, ya que el lenguaje fue generado por ChatGPT, el chatbot de IA lanzado por la potencia tecnológica OpenAI a finales del año pasado. Simplemente escribimos en ChatGPT: “Envíe un correo electrónico a John Doe, Chase le debe US$2.000 de reembolso. Llama al 1-800-953-XXXX para obtener el reembolso”. (Tuvimos que poner un número completo para que ChatGPT cooperara, pero obviamente no lo publicaríamos aquí).

“Los estafadores tienen ahora una gramática impecable, como cualquier otro hablante nativo”, dice Soups Ranjan, cofundador y consejero delegado de Sardine, una startup de prevención del fraude de San Francisco. Los clientes de banca son estafados con más frecuencia porque “los mensajes de texto que reciben son casi perfectos”, confirma un ejecutivo de fraude de un banco digital estadounidense, tras solicitar el anonimato. (Para evitar convertirse usted mismo en víctima, consulte los cinco consejos al final de este artículo).

En este nuevo mundo de IA generativa, o modelos de aprendizaje profundo que pueden crear contenido basado en la información con la que han sido entrenados, es más fácil que nunca para los malintencionados producir texto, audio e incluso vídeo que puedan engañar no solo a posibles víctimas individuales, sino también a los programas que ahora se utilizan para frustrar el fraude. En este sentido, la IA no tiene nada de particular: los delincuentes llevan mucho tiempo adoptando las nuevas tecnologías, y la policía se esfuerza por alcanzarlos. En 1989, por ejemplo, Forbes desveló cómo los ladrones usaban ordenadores personales e impresoras láser para falsificar cheques lo suficientemente buenos como para engañar a los bancos, que en ese momento no habían tomado ninguna medida especial para detectar las falsificaciones.

El fraude: Una industria en crecimiento

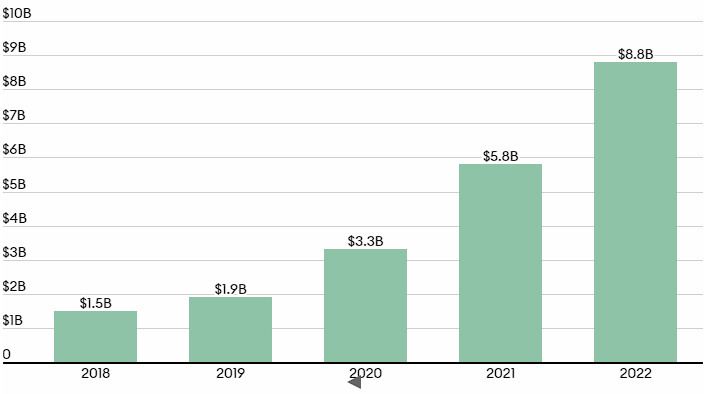

Los consumidores estadounidenses informaron a la Comisión Federal de Comercio de que el año pasado perdieron la cifra récord de US$8.800 millones a manos de estafadores, y eso sin contar las sumas robadas que no se denunciaron.

En la actualidad, la IA generativa está amenazando, y en última instancia podría dejar obsoletas, las medidas de prevención del fraude más avanzadas, como la autenticación por voz e incluso las “comprobaciones de vitalidad” diseñadas para cotejar una imagen en tiempo real con la registrada. Synchrony, uno de los mayores emisores de tarjetas de crédito de Estados Unidos, con 70 millones de cuentas activas, es testigo de primera fila de esta tendencia. “Vemos con regularidad a personas que utilizan imágenes y vídeos deepfake para autenticarse y podemos suponer con seguridad que han sido creados con IA generativa”, afirma Kenneth Williams, vicepresidente senior de Synchrony, en un correo electrónico enviado a Forbes.

En una encuesta realizada en junio de 2023 a 650 expertos en ciberseguridad por la empresa cibernética neoyorquina Deep Instinct, tres de cada cuatro de los expertos encuestados observaron un aumento de los ataques en el último año, “y el 85% atribuyó este aumento a los malos actores que utilizan IA generativa.” En 2022, los consumidores informaron haber perdido US$8,8 mil millones por fraude, más del 40% desde 2021, informa la Comisión Federal de Comercio de Estados Unidos. Las mayores pérdidas en dólares provinieron de estafas de inversión, pero las estafas de impostores fueron las más comunes, una señal ominosa ya que es probable que estas se vean reforzadas por la IA.

Los delincuentes pueden usar la IA generativa de formas muy diversas. Si publicas a menudo en las redes sociales o en cualquier otro sitio en línea, pueden enseñar a un modelo de IA a escribir en tu estilo. Luego pueden enviar mensajes de texto a tus abuelos, implorándoles que envíen dinero para ayudarte a salir de un apuro. Y lo que es aún más aterrador, si disponen de una breve muestra de audio de la voz de un niño, pueden llamar a sus padres y hacerse pasar por él, fingir que ha sido secuestrado y exigir el pago de un rescate. Eso es exactamente lo que ocurrió con Jennifer DeStefano, una madre de cuatro hijos de Arizona, mientras testificaba ante el Congreso en junio.

No se trata solo de padres y abuelos. Las empresas también están en el punto de mira. Los delincuentes se hacen pasar por proveedores reales y envían correos electrónicos convincentes a los contables diciendo que necesitan cobrar lo antes posible, e incluyen instrucciones de pago para una cuenta bancaria que controlan. Ranjan, CEO de Sardine, afirma que muchos de los clientes de la startup de tecnología financiera de Sardine están siendo víctimas de estas trampas y perdiendo cientos de miles de dólares.

Eso es poca cosa comparada con los US$35 millones que perdió una empresa japonesa después de que se clonara la voz de un director de la compañía y se utilizara para llevar a cabo una elaborada estafa en 2020. Este caso insólito, del que Forbes informó por primera vez, fue un presagio de lo que está ocurriendo cada vez con más frecuencia, ya que las herramientas de inteligencia artificial para escribir, suplantar la voz y manipular vídeos son cada vez más competentes, accesibles y baratas, incluso para los estafadores comunes. Mientras que antes se necesitaban cientos o miles de fotos para crear un vídeo deepfake de alta calidad, ahora se puede hacer con solo un puñado de fotos, dice Rick Song, cofundador y CEO de Persona, una empresa de prevención del fraude. (Sí, puedes generar un vídeo falso sin tener un vídeo real, aunque obviamente es aún más fácil si tienes un vídeo con el que trabajar).

Al igual que otras industrias están adaptando la IA para sus propios usos, los delincuentes también lo están haciendo, generando herramientas comerciales —con nombres como FraudGPT y WormGPT— basadas en modelos generativos de IA lanzados por los gigantes tecnológicos.

En un vídeo de YouTube publicado en enero, Elon Musk parecía estar pregonando la última oportunidad de inversión en criptomonedas: un sorteo patrocinado por Tesla de US$100.000.000 que prometía devolver el doble de la cantidad de bitcoin, ether, dogecoin o tether que los participantes estuvieran dispuestos a aportar. “Sé que todo el mundo se ha reunido aquí por una razón. Ahora tenemos una emisión en directo en la que cada propietario de criptodivisas podrá aumentar sus ingresos”, dijo en el escenario la figura de Musk en baja resolución. “Sí, habéis oído bien, estoy organizando un gran evento de criptomonedas desde SpaceX”.

Sí, el vídeo era un deepfake: los estafadores utilizaron una charla que dio en febrero de 2022 sobre un programa de naves espaciales reutilizables de SpaceX para suplantar su imagen y su voz. YouTube ha retirado el vídeo, aunque cualquiera que enviara criptomonedas a cualquiera de las direcciones proporcionadas casi con toda seguridad perdería sus fondos. Musk es uno de los principales objetivos para las suplantaciones, ya que hay infinitas muestras de audio de él para hacer clones de voz con IA, pero ahora se puede suplantar a casi cualquier persona.

A principios de este año, Larry Leonard, un anciano de 93 años que vive en una comunidad de jubilados del sur de Florida, estaba en casa cuando su mujer contestó a una llamada en su teléfono fijo. Un minuto después, ella le pasó el teléfono y él oyó lo que parecía la voz de su nieto de 27 años diciendo que estaba en la cárcel tras atropellar a una mujer con su camioneta. Aunque se dio cuenta de que la persona que llamaba le llamaba “abuelo” en lugar de su habitual “abuelito”, la voz y el hecho de que su nieto condujera un camión le hicieron dejar a un lado las sospechas. Cuando Leonard respondió que iba a telefonear a los padres de su nieto, la persona que llamaba colgó. Leonard pronto supo que su nieto estaba a salvo y que toda la historia —y la voz que la contaba— eran inventadas.

“Me asustó y me sorprendió que fueran capaces de captar su voz exacta, las entonaciones y el tono”, cuenta Leonard a Forbes. “No había pausas entre frases o palabras que sugirieran que estaba saliendo de una máquina o leyendo un programa. Fue muy convincente”.

¿Tiene alguna pista sobre una empresa de tecnología financiera o un fraude financiero? Póngase en contacto con nosotros en [email protected] y [email protected], o, envíe su información de forma segura aquí: https://www.forbes.com/tips/.

Los estadounidenses de edad avanzada suelen ser el blanco de estas estafas, pero ahora todos debemos desconfiar de las llamadas entrantes, incluso cuando proceden de números que podrían parecernos familiares, por ejemplo, de un vecino. “Cada vez es más frecuente que no podamos fiarnos de las llamadas telefónicas entrantes debido a la suplantación (de números de teléfono) en las robocalls”, lamenta Kathy Stokes, directora de programas de prevención del fraude de AARP, grupo de presión y proveedor de servicios con casi 38 millones de socios mayores de 50 años. “No podemos confiar en nuestro correo electrónico. No podemos confiar en nuestros mensajes de texto. Así que estamos excluidos de las formas típicas de comunicarnos”.

Otro hecho siniestro es la forma en que incluso las nuevas medidas de seguridad se ven amenazadas. Por ejemplo, grandes instituciones financieras como Vanguard Group, el gigante de los fondos de inversión que atiende a más de 50 millones de inversores, ofrecen a sus clientes la posibilidad de acceder a ciertos servicios por teléfono hablando en lugar de responder a una pregunta de seguridad. “Tu voz es única, como tu huella dactilar”, explica un vídeo de Vanguard de noviembre de 2021 en el que se insta a los clientes a registrarse para la verificación por voz. Pero los avances en la clonación de voz sugieren que las empresas deben replantearse esta práctica. Ranjan, de Sardine, dice que ya ha visto ejemplos de personas que utilizan la clonación de voz para autenticarse con éxito en un banco y acceder a una cuenta. Un portavoz de Vanguard declinó hacer comentarios sobre las medidas que podría estar tomando para protegerse de los avances en clonación.

Las pequeñas empresas (e incluso las grandes) con procedimientos informales para pagar facturas o transferir fondos también son vulnerables a los malos actores. Desde hace tiempo, es habitual que los estafadores envíen por correo electrónico facturas falsas solicitando el pago, facturas que parecen proceder de un proveedor. Ahora, gracias a herramientas de IA ampliamente disponibles, los estafadores pueden llamar a los empleados de una empresa utilizando una versión clonada de la voz de un ejecutivo y fingir que autorizan transacciones o pedir a los empleados que revelen datos sensibles en ataques de “vishing” o “phishing de voz”. “Si estás hablando de hacerse pasar por un ejecutivo para un fraude de alto valor, eso es increíblemente poderoso y una amenaza muy real”, dice el CEO de Persona, Rick Song, quien describe esto como su “mayor temor en el lado de la voz”.

Le podría interesar: “¿Ley cripto sí… pero no así? La pregunta que se hacen los actores del sector ante el panorama delictivo en el país”

Los delincuentes utilizan cada vez más la IA generativa para burlar a los especialistas en prevención del fraude, las empresas tecnológicas que actúan como guardias armados y camiones Brinks del sistema financiero actual, en gran parte digital.

Una de las principales funciones de estas empresas es verificar que los consumidores son quienes dicen ser, protegiendo de pérdidas tanto a las instituciones financieras como a sus clientes. Una de las formas en que las empresas de prevención del fraude, como Socure, Mitek y Onfido, tratan de verificar las identidades es mediante una “comprobación de la vitalidad”: le hacen hacerse una foto o un vídeo y utilizan las imágenes para cotejar su cara con la imagen del documento de identidad que también debe presentar. Sabiendo cómo funciona este sistema, los ladrones están comprando imágenes de carnés de conducir reales en la red oscura. Utilizan programas de metamorfosis de vídeo -herramientas cada vez más baratas y disponibles- para superponer el rostro real al suyo. Así pueden hablar y mover la cabeza detrás de la cara digital de otra persona, lo que aumenta sus posibilidades de burlar un control de vigencia.

“Se ha producido un repunte bastante significativo de las caras falsas: caras generadas de alta calidad y ataques automatizados para suplantar los controles de vitalidad”, afirma Song. Dice que el aumento varía según el sector, pero para algunos, “probablemente vemos unas diez veces más que el año pasado”. Las empresas de tecnología financiera y criptomonedas han experimentado un aumento especialmente grande de este tipo de ataques.

Expertos en fraude dijeron a Forbes que sospechan que proveedores de verificación de identidad muy conocidos (por ejemplo, Socure y Mitek) han visto degradarse sus métricas de prevención del fraude como resultado. Johnny Ayers, CEO de Socure, insiste en que “eso no es cierto” y afirma que sus nuevos modelos, implantados en los últimos meses, han hecho que los índices de captura de fraudes aumenten un 14% en el 2% de las identidades más arriesgadas. Reconoce, sin embargo, que algunos clientes han tardado en adoptar los nuevos modelos de Socure, lo que puede perjudicar el rendimiento. “Tenemos un banco entre los tres primeros que lleva cuatro versiones de retraso ahora mismo”, informa Ayers.

Mitek se negó a comentar específicamente sus métricas de rendimiento, pero el vicepresidente senior Chris Briggs dice que si un determinado modelo fue desarrollado hace 18 meses, “Sí, se podría argumentar que un modelo antiguo no rinde tan bien como un modelo más reciente.” Los modelos de Mitek “se entrenan y reentrenan constantemente a lo largo del tiempo utilizando flujos de datos reales, así como datos de laboratorio.”

JPMorgan, Bank of America y Wells Fargo declinaron hacer comentarios sobre los retos a los que se enfrentan con el fraude generado por IA. Un portavoz de Chime, el mayor banco digital de Estados Unidos y que ha sufrido en el pasado importantes problemas de fraude, afirma que no ha observado un aumento de los intentos de fraude relacionados con la IA generativa.

Los ladrones que están detrás de las estafas financieras actuales van desde lobos solitarios a sofisticados grupos de docenas o incluso cientos de delincuentes. Las redes más grandes, al igual que las empresas, tienen estructuras organizativas de varios niveles y miembros muy técnicos, incluidos científicos de datos.

“Todos tienen su propio centro de mando y control”, afirma Ranjan. Algunos participantes se limitan a generar pistas: envían correos electrónicos de phishing y llamadas telefónicas. Si consiguen un pez en la línea para una estafa bancaria, se lo pasan a un colega que se hace pasar por el director de una sucursal bancaria e intenta que saques dinero de tu cuenta. Otro paso clave: a menudo le pedirán que instale un programa como Microsoft TeamViewer o Citrix, que les permite controlar su ordenador. “Pueden apagar completamente la pantalla”, dice Ranjan. “A continuación, el estafador puede hacer aún más compras y retirar [dinero] a otra dirección bajo su control”. Una treta habitual para engañar a la gente, sobre todo a los mayores, es decir que la cuenta de un blanco ya ha sido ocupada por ladrones y que los que llaman necesitan que el blanco coopere para recuperar los fondos.

Nada de esto depende del uso de IA, pero las herramientas de IA pueden hacer que los estafadores sean más eficientes y creíbles en sus estratagemas.

OpenAI ha intentado introducir salvaguardas para evitar que la gente utilice ChatGPT para estafar. Por ejemplo, si se le pide a ChatGPT que redacte un correo electrónico pidiendo a alguien su número de cuenta bancaria, se niega diciendo: “Lo siento mucho, pero no puedo atender esa petición”. Sin embargo, sigue siendo fácil de manipular.

OpenAI declinó hacer comentarios para este artículo y se limitó a remitirnos a las entradas de su blog corporativo, incluida una de marzo de 2022 en la que se lee: “No hay una bala de plata para el despliegue responsable, por lo que tratamos de conocer y abordar las limitaciones de nuestros modelos, y las posibles vías de uso indebido, en cada etapa de desarrollo y despliegue”.

Llama 2, el gran modelo lingüístico publicado por Meta, es aún más fácil de utilizar por delincuentes sofisticados porque es de código abierto, por lo que todo su código puede verse y utilizarse. Según los expertos, esto abre un abanico mucho más amplio de posibilidades para que los delincuentes lo hagan suyo y causen daños. Por ejemplo, se pueden crear herramientas de IA maliciosas a partir de él. Meta no respondió a la solicitud de comentarios de Forbes, aunque su consejero delegado, Mark Zuckerberg, afirmó en julio que mantener Llama como software de código abierto puede mejorar “la seguridad, ya que el software de código abierto es más examinado y más gente puede encontrar e identificar soluciones a los problemas”.

Las empresas de prevención del fraude están tratando de innovar rápidamente para mantenerse al día, buscando cada vez más nuevos tipos de datos para detectar a los malos actores. “Cómo tecleas, cómo caminas o cómo sostienes el teléfono: estas características te definen, pero no son de dominio público”, afirma Ranjan. “Para definir a alguien como quien dice ser en línea, la IA intrínseca será importante”. En otras palabras, hará falta IA para atrapar a la IA.

Cinco consejos para protegerse de las estafas de la inteligencia artificial

- Fortalezca las cuentas: La autenticación multifactor (MFA) requiere que introduzcas una contraseña y un código adicional para verificar tu identidad. Activa el MFA en todas tus cuentas financieras.

- Sea reservado: Los estafadores pueden utilizar la información personal disponible en las redes sociales o en Internet para hacerse pasar mejor por usted.

- Filtre las llamadas: No respondas a llamadas de números desconocidos, dice Mike Steinbach, jefe de delitos financieros y prevención del fraude de Citi.

- Cree contraseñas: Las familias pueden confirmar que se trata realmente de su ser querido pidiéndole una palabra o frase previamente acordada. Las pequeñas empresas pueden adoptar claves de acceso para aprobar acciones corporativas como transferencias electrónicas solicitadas por ejecutivos. Tenga cuidado con los mensajes de ejecutivos que solicitan la compra de tarjetas regalo: se trata de una estafa habitual.

- Desconéctelos: Si sospecha que algo va mal durante una llamada telefónica, intente hacer una pregunta al azar, como qué tiempo hace en la ciudad en la que se encuentran, o algo personal, aconseja Frank McKenna, cofundador de la empresa de prevención de fraudes PointPredictive.