Social Links, una empresa de vigilancia a la que se bloquearon miles de cuentas después de que Meta la acusara de espionaje masivo en Facebook e Instagram, utiliza ahora ChatGPT para dar sentido a los datos que su software obtiene de las redes sociales.

La mayoría de la gente utiliza ChatGPT para responder a consultas sencillas, redactar correos electrónicos o producir código útil (e inútil). Pero las empresas de software espía están estudiando cómo utilizarlo, junto con otras herramientas de IA emergentes, para vigilar a la gente en las redes sociales.

En una presentación en la conferencia de seguridad nacional Milipol, celebrada en París el martes, la empresa de vigilancia en línea Social Links mostró cómo ChatGPT realiza “análisis de sentimientos”, en los que la IA evalúa el estado de ánimo de los usuarios de las redes sociales o puede destacar los temas más debatidos en un grupo. Esto puede ayudar a predecir si la actividad en línea desembocará en violencia física y requerirá la actuación de las fuerzas de seguridad.

Fundada por el empresario ruso Andrey Kulikov en 2017, Social Links tiene ahora oficinas en los Países Bajos y Nueva York; anteriormente, Meta calificó a la empresa de proveedor de software espía a finales de 2022, prohibiendo 3.700 cuentas de Facebook e Instagram que supuestamente utilizaba para rastrear repetidamente los sitios sociales. La empresa niega cualquier vínculo con esas cuentas y la denuncia de Meta no ha perjudicado su crecimiento: el ejecutivo de ventas de la empresa, Rob Billington, dijo que la empresa tenía más de 500 clientes, la mitad de los cuales tenían su sede en Europa, con poco más de 100 en América del Norte. El hecho de que Social Links utilice ChatGPT demuestra que la herramienta de OpenAI de 2023 puede potenciar un sector de la vigilancia ansioso por promocionar la inteligencia artificial como herramienta para la seguridad pública.

“Nunca va a haber una manera de hacer que la IA sea imparcial…”

Andy Martin, ingeniero de Cellebrite

Sin embargo, según Jay Stanley, analista político de la Unión Americana de Libertades Civiles, el uso de herramientas de inteligencia artificial como ChatGPT para aumentar la vigilancia de las redes sociales probablemente “ampliará la vigilancia individualizada de una forma que nunca podría hacerse con monitores humanos”, declaró a Forbes.

Esto es un problema no solo porque este tipo de escucha tecnológica podría amplificar las inexactitudes o los prejuicios. También podría enfriar el discurso en línea porque todo el mundo siente “que está siendo vigilado, no necesariamente por humanos, sino por agentes de IA que tienen la capacidad de informar de cosas a humanos que pueden traer consecuencias sobre tu cabeza”, añadió Stanley.

OpenAI, fabricante de ChatGPT, no respondió a las peticiones de comentarios. Su política de uso dice que no permite “actividades que violen la privacidad de las personas”, incluido el “seguimiento o monitorización de un individuo sin su consentimiento”.

“Nos adherimos estrictamente a las políticas de OpenAI”, dijo el director de comunicaciones de Social Links, Héctor Talavera. “Solo usamos ChatGPT para analizar texto, incluyendo resumir contenido, identificar temas, clasificar texto como positivo, neutral o negativo, y evaluar el sentimiento para varios elementos en el texto”. (También reiteró una declaración anterior, en la que la empresa dijo que nunca tuvo vínculos con el gobierno ruso y Kulikov condenó la invasión rusa de Ucrania).

El portavoz de Meta, Ryan Brack, dijo que la empresa cuenta con un equipo de más de 100 personas centradas en la lucha contra el scraping no autorizado. “Hacemos cumplir nuestras políticas contra el scraping no autorizado, incluyendo acciones legales, cuando descubrimos que se han violado nuestros términos”, dijo Brack.

Talavera, de Social Links, dijo que Meta había cometido un error al vincularla a las 3.700 cuentas prohibidas, y añadió que la empresa no realiza raspado masivo de redes sociales. En lugar de ello, el usuario pide a Social Links que recopile las publicaciones relevantes para su investigación, que el usuario puede analizar en la interfaz de usuario de Social Links. Los datos se almacenan en el ordenador del usuario, no en un servidor de Social Links. “Es más cómodo y eficaz que utilizar Google y los navegadores web, pero básicamente es lo mismo”, añade Talavera.

Sigue siendo una potente herramienta para supervisar las actividades en línea de las personas, que la empresa promociona como útil para seguir los movimientos de protesta. En una demostración de la conferencia, el analista de Social Links, Bruno Alonso, utilizó el software para evaluar la reacción en línea al polémico acuerdo alcanzado recientemente por el presidente del Gobierno español en funciones para amnistiar a los políticos catalanes que intentaron conseguir la independencia regional en 2017. La herramienta escaneó Twitter en busca de publicaciones que contuvieran palabras clave y hashtags, incluido “amnistía”, y las pasó por ChatGPT, que evaluó su sentimiento como positivo, negativo o neutro, mostrando los resultados en un gráfico interactivo. La herramienta también es capaz de resumir y diseccionar rápidamente los debates en línea en las principales plataformas, como Facebook, seleccionando los temas más debatidos.

Según la presentación de Alonso, Social Links también permite buscar coincidencias de reconocimiento facial una vez que la herramienta ha detectado que alguien presenta un sentimiento “negativo” en las redes sociales. El usuario puede tomar un rostro y, utilizando los algoritmos propios de Social Links, buscar coincidencias en las redes sociales, lo que ofrece a la policía una visión más amplia de la identidad del individuo. “Las posibilidades son realmente infinitas”, añadió Alonso. Talavera explicó que la empresa no almacena imágenes faciales, sino que busca coincidencias en Internet. Añadió que era similar a una búsqueda inversa de imágenes en Google, aunque Social Links también utiliza su propio software de reconocimiento facial que puede buscar en grupos públicos de redes sociales y en las colecciones de fotos de los usuarios.

La demostración fue una de las muchas centradas en la inteligencia artificial en Milipol, una extensa feria comercial en la que las empresas comercializan armamento y tecnología de vigilancia para las fuerzas del orden y las agencias de seguridad nacional. Andy Martin, ingeniero británico del gigante israelí del análisis forense de teléfonos inteligentes Cellebrite, afirmó que los grandes modelos lingüísticos como ChatGPT van a ser enormemente beneficiosos para todo tipo de operaciones policiales; desde el análisis de registros de llamadas para encontrar anomalías en el “patrón de vida” de una persona hasta los “interrogatorios aumentados”, en los que la IA proporcionará información al entrevistador durante el interrogatorio.

No obstante, advirtió de que las fuerzas de seguridad deben ser transparentes en el uso de la inteligencia artificial por sus problemas de fiabilidad y parcialidad. “Nunca va a haber una forma de hacer que la IA sea imparcial”, dijo, señalando, como han hecho otros, que las tecnologías programadas por humanos reflejan la falibilidad humana.

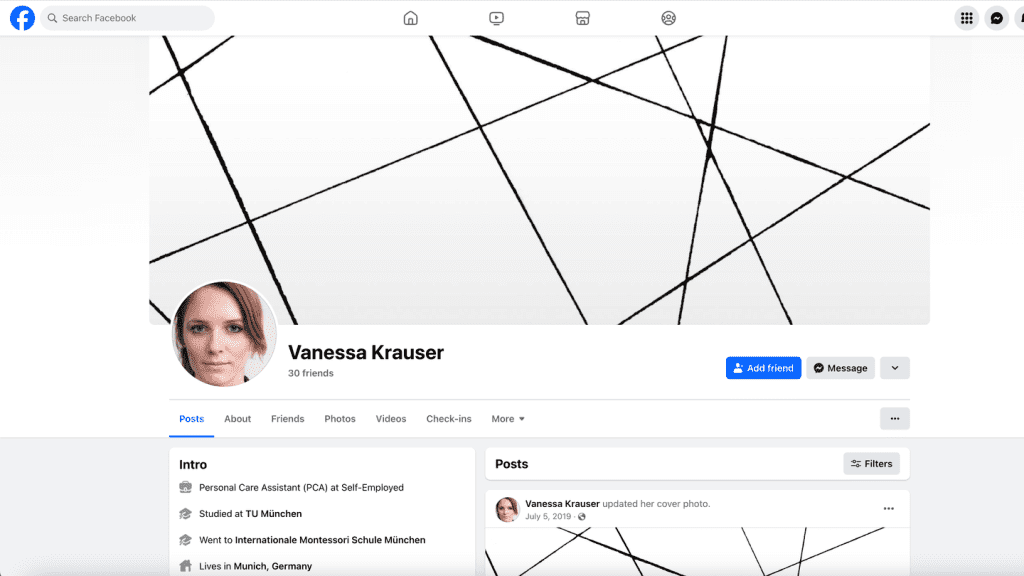

También asistieron: La empresa italiana de vigilancia Cy4gate, cuya nueva herramienta Gens.AI, crea perfiles humanos convincentes en las redes sociales a partir de una lista de características. La IA no solo genera avatares de aspecto legítimo, sino que también puede soltarlos en plataformas como Facebook y Telegram como personajes autónomos de IA. Estos perfiles falsos son utilizados por investigadores encubiertos para obtener más información sobre un sospechoso, aunque normalmente están controlados por humanos, no por IA. Cy4gate afirma que sus avatares son lo suficientemente realistas como para “acercarse al objetivo y establecer una relación de confianza” y evitar ser detectados. Un avatar de Forbes generado por Gens.AI y exhibido en Milipol —una mujer de unos 30 años, entrenadora personal— estaba activo en las redes sociales, incluido Facebook, donde había estado activo desde 2019.

Meta prohíbe las cuentas policiales encubiertas. Poco después de que Forbes señalara la cuenta a Meta, fue eliminada.

La combinación de empresas como Social Links y Gens.AI conduce a la posibilidad muy real de un extraño tipo de cámara de eco de IA, donde el software de vigilancia de redes sociales de IA creado por una empresa de software espía se utiliza para supervisar personas de IA creadas por otra, con ChatGPT y otros LLM en la mezcla. En una frase: el amanecer del canibalismo de la vigilancia de la IA.